Una sintetica storia del computer

Quando parliamo di computer, l’idea che abbiamo è quella dei moderni dispositivi che ormai conosciamo bene e che la maggior parte di noi utilizza quasi ogni giorno. In realtà la storia del computer, inteso nel senso letterale del termine, ovvero dal latino computare, risale a tempi molto antichi e si lega all’esigenza dell’essere umano di eseguire calcoli e risolvere problemi sempre più complessi in modo preciso e veloce.

Per ripercorrere la storia del computer bisogna pensare che moltissimi sono stati nel tempo i contributi e gli studi che si sono integrati e talvolta anche sovrapposti, e che quindi non è facile definire un percorso lineare che ha portato all’attuale tecnologia. I primi passi, comunque, sono quelli che si muovono in direzione delle macchine calcolatrici.

Se la nascita dell’informatica moderna si fa risalire al Novecento, è l’abaco da considerarsi il più antico strumento progenitore dei computer. Inventato per effettuare operazioni matematiche, l’abaco è già utilizzato duemila anni prima di Cristo in Cina e nella regione della Mezzaluna Fertile, poi adottato da Greci e Romani e ancora utilizzato in molte parti del mondo.

Seguono poi diversi altri dispositivi inventati e impiegati per contare e misurare, dotati anche di grande precisione, fino ad arrivare all’astrolabio e agli orologi astronomici.

Un notevole impulso si è avuto sicuramente a partire dal Seicento con invenzioni che intendevano avere applicazioni pratiche in astronomia e in altri ambiti della scienza, a partire dai regoli calcolatori e altri strumenti di calcolo realizzati da scienziati quali Edmund Gunter, Wilhelm Schickard (il quale anticipa di circa vent’anni la poi più conosciuta macchina di Pascal) e William Oughtred, o come quella del matematico scozzese John Napier, barone di Merchiston, ovvero i cosiddetti Bastoncini (o bacchette) di Nepero, che si basavano sulla già diffusa moltiplicazione araba.

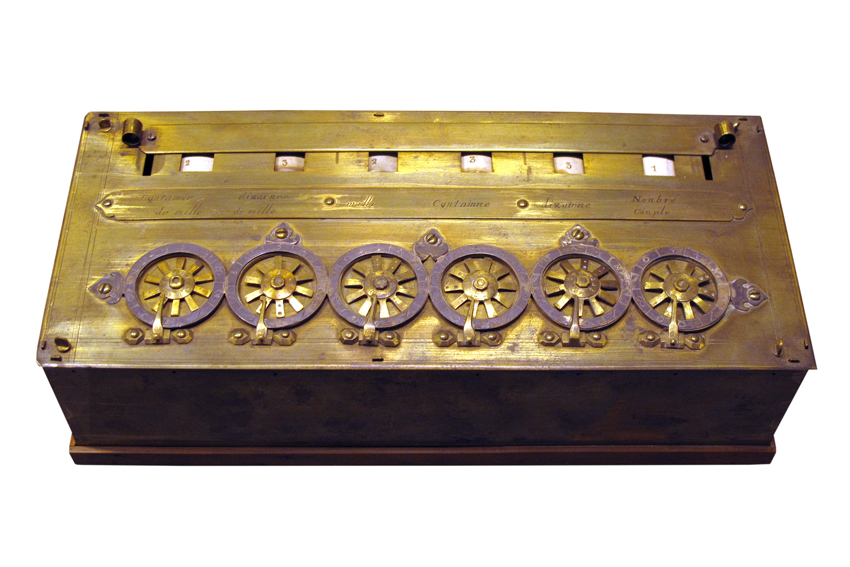

Si arriva quindi alla prima macchina per addizioni e sottrazioni matematiche ideata da Blaise Pascal, la cosiddetta Pascaline, un congegno meccanico dotato di ingranaggi rotanti in grado di addizionare e sottrarre numeri composti da un massimo di dodici cifre, operando automaticamente i riporti, poi migliorato da Gottfried Wilhelm von Leibniz con la macchina calcolatrice Stepped Reckoner, in grado anche di moltiplicare e dividere.

Un contributo, tra fine Settecento e inizio Ottocento, viene dato anche dalla messa a punto dei telai automatici progettati da Joseph-Marie Jacquard (ogni schema di lavorazione aveva una sua scheda perforata; oggi si potrebbe dire un proprio programma o software), per poi proseguire con macchine sempre più complesse quali la macchina differenziale e le macchine analitiche ideate nell’Ottocento da matematici quali Charles Babbage (il quale adottò il sistema a schede perforate di Jacquard) e Ada Augusta Byron Lovelace (la prima a scrivere il primo esempio di software, con la stessa architettura dei moderni computer), con l’idea di realizzare calcolatori programmabili, prototipi dei computer meccanici, e che si avvicinano ancora di più alla struttura dei moderni computer, in quanto costituiti da uno store per conservare i dati, un’unità di calcolo e una stampante, in grado di svolgere, oltre a calcoli, anche vari compiti matematici.

Macchine che ancora avevano difficoltà ad essere addirittura costruite, dalle dimensioni spropositate, che se anche spesso rimasero sulla carta, aprirono però la strada ai nostri moderni PC.

Altro impulso per la realizzazione dei computer viene dagli studi di algebra del britannico George Boole, il fondatore della logica matematica, su cui si basa la progettazione teorica dei computer, considerato quindi da molti uno dei padri dell’era digitale.

Se consideriamo i primi computer analogici dobbiamo riferirci ai primi anni del XX secolo, quando i progetti dei primi calcolatori meccanici e successivamente elettrici iniziano a trovare applicazione soprattutto tra le due guerre mondiali.

È quasi contemporanea la progettazione di macchine elettroniche progenitrici degli attuali computer digitali: negli Stati Uniti nel 1939 viene messa a punto l’ABC, ideato da John Atanasoff e Clifford Berry, una macchina elettronica per la soluzione dei sistemi di equazioni lineari ma non in grado di memorizzare i programmi, la prima comunque a implementare le idee fondamentali alla base dei moderni computer, mentre nel 1944 viene assemblato il primo Colossus, che verrà utilizzato dalle forze armate britanniche durante la seconda guerra mondiale per cercare di decifrare i messaggi radio dei nazisti, una macchina programmabile, la prima a utilizzare le valvole termioniche, progettata da Max Newman sulla base degli studi della macchina ideata dal matematico inglese Alan Turing, oggi considerato uno dei padri dell’informatica, il quale ha gettato le basi per lo sviluppo dell’intelligenza artificiale e dal quale si fa iniziare la storia moderna del computer.

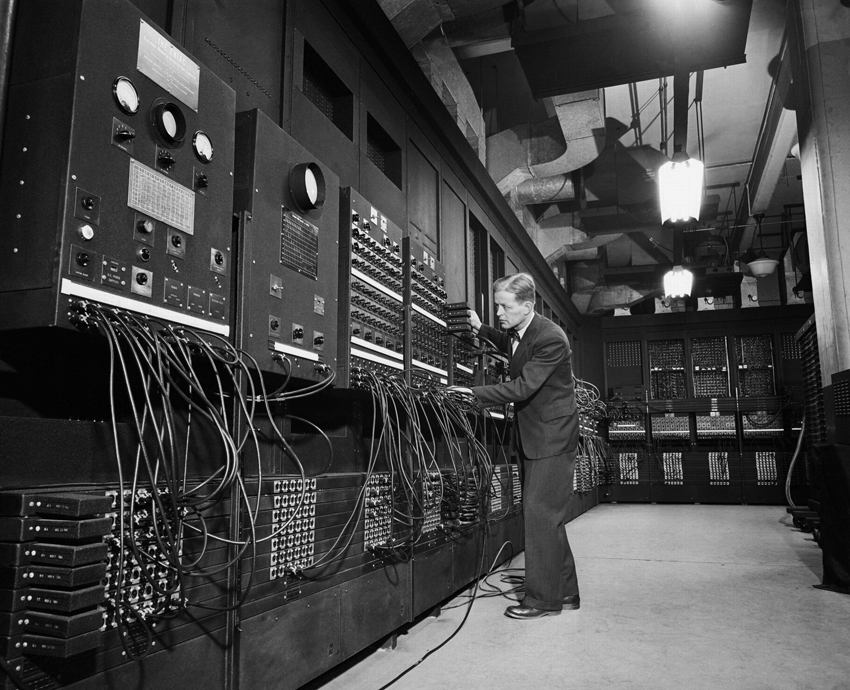

Studi che portarono alla realizzazione nei laboratori IBM del gigantesco calcolatore elettromeccanico Harvard Mark 1, progettato da Howard Hathaway Aiken, e, poco dopo, alla progettazione di ENIAC (Electronic Numerical Integrator and Computer), operativo nel 1946, che occupava una stanza della superficie di circa centottanta metri quadrati, pesava quasi trenta tonnellate, era composto da diciottomila valvole e aveva una velocità di varie centinaia di moltiplicazioni al minuto (certo: una potenza di calcolo di molto inferiore a quella di un PC odierno, ma già un vero traguardo) e poi all’elaboratore elettronico EDVAC, realizzato sugli studi del matematico ungherese naturalizzato statunitense John von Neumann (il primo a intuire la possibilità di creare una macchina il cui programma potesse essere memorizzato nella macchina stessa), composto da un processore centrale, un magazzino dove erano salvati i dati di input e di output e di una parte che li collegava tra loro, qualcosa insomma che sta alla base dei moderni computer.

È negli anni Cinquanta del secolo scorso che, con l’invenzione dei transistor, si possono iniziare a realizzare macchine di dimensioni più piccole. È questa l’era che porta alla seconda generazione di computer: quella costituita da elaboratori più evoluti, meno ingombranti, veloci ed economici quali ad esempio l’IBM 1401, lanciato nel 1959.

Con la comparsa dei circuiti integrati, conosciuti poi come microchip, inventati da Kilby (Nobel per la fisica) e Noyce, fondatore poi della Intel, dalla fine degli anni Sessanta si entra nella terza generazione di computer, i quali diventano ancora più economici, più compatti e in grado di poter svolgere molte più funzioni.

Sarà la Intel infatti che commercializzerà nel ‘71 il primo microprocessore, l’Intel 4004, e sempre alla Intel si deve quello che potrebbe essere considerato il primo microcomputer, il SDK80, prodotto nel 1975 come aiuto e supporto ai progettisti. Nel frattempo inizia a farsi conoscere l’utilizzo del mouse, presentato da Douglas Engelbart nel 1968 e in seguito adottato da Apple per i suoi computer Lisa e Macintosh.

Con la realizzazione di microcomputer quali l’Altair 8800, proposto in scatola di montaggio, e l’Apple-1 (il primo computer realizzato da Apple, commercializzato poi come Apple II dal 1977 come home computer) si entra nell’era della quarta generazione.

È negli anni Ottanta del secolo scorso che si ha il vero boom dell’informatica. Nel 1981 IBM lancia il suo primo PC, il PC 5150, e nello stesso anno Xerox introduce Xerox 8010, il primo sistema a interfaccia grafica, che sarà poi alla base della produzione Apple per il suo Macintosh, che verrà lanciato sul mercato nel 1984, diventando il primo computer “di massa”.

La sfida, adesso, è quella dei computer portatili, di cui va ricordato il Compaq Portable, IBM compatibile, e lo sviluppo di software per consentire a più PC di condividere lo stesso hard disk.

Anche se risalgono agli anni Cinquanta i primi progetti che riguardano la possibilità di collegare gli utenti di diversi computer e agli anni successivi la realizzazione di una prima rete (Arpanet), è dagli anni Ottanta che la tecnologia si sviluppa in modo tale da consentire la realizzazione di Internet come oggi lo conosciamo, diffuso negli anni Novanta grazie allo sviluppo del World Wide Web ideato da Tim Berners-Lee insieme a Robert Cailliau, che dal 1995 ha iniziato a diffondersi e a diventare parte integrante della nostra economia e della nostra vita quotidiana.

Una storia, quella dei computer, che ha origini lontane, quindi, ma che ha fatto passi da gigante in pochi decenni, e che oggi continua a progredire verso nuovi studi e applicazioni e che, a partire dalle intuizioni del premio Nobel per la fisica Murray Gell-Mann, ha intrapreso la strada dell’utilizzo dei fenomeni della meccanica quantistica e quindi del comportamento delle particelle elementari per dar vita a nuove generazioni di computer sempre più sofisticati, con sempre maggiore potenza di calcolo e adattabili a nuove applicazioni.

Alessandra Buschi