Codice binario: quando i numeri diventano un linguaggio

Ci sono solo 10 tipi di persone: quelle che conoscono la numerazione binaria e quelle che non la capiscono.

Questa battuta è ben conosciuta, ma in effetti non sono in tanti a sapere davvero cosa sia e come funzioni il codice binario, nonostante ogni linguaggio di programmazione lo sottintenda e rappresenti la base di ogni processo di calcolo.

Il codice binario – in realtà il nome matematicamente corretto sarebbe sistema numerico binario – è un sistema numerico che si esprime in base due: utilizza cioè due sole cifre invece delle dieci a cui siamo abituati. Di solito si tratta di 0 e 1. Il motivo per cui è detto codice è che attraverso questi due numeri un computer può codificare o decodificare informazioni più complesse e gestirle nelle proprie routine di calcolo.

Il modo con cui un computer “pensa” si traduce in rielaborare ogni informazione ad una velocità quasi incomprensibile per il cervello umano, traducendole tutte in sequenze di 0 ed 1. Ciò significa che tutte le funzioni del computer verranno rapidamente elaborate passare da 00 o 01 ad una velocità difficilmente comprensibile per il cervello umano. Allo stesso tempo, però, il cervello umano funziona in modo “olistico”, ad una velocità molto più rapida che un computer nell’eseguire operazioni molto complesse, come i ragionamenti e le analisi di processo.

Ogni cifra binaria è chiamata bit, e ciascun bit può ovviamente rappresentare due diversi valori: 0 e 1. Per rappresentare più di due valori, si necessitano più bit. Ad esempio, due bit combinati possono essere utilizzati per rappresentare quattro diversi valori: 0 0, 0 1, 1 0, 1 e 1.

Di conseguenza, più i numeri crescono, più aumentano i bit di cui si ha bisogno per rappresentarli. Quando si dice che un computer utilizza un’architettura a 32-bit o 64-bit, si intende parlare del numero massimo di cifre binarie che possono essere utilizzate per rappresentare un singolo valore. Un totale di 32 bit può essere utilizzato per rappresentare 2 alla trentaduesima potenza di valori diversi, cioè un totale di 4.294.967.295 valori.

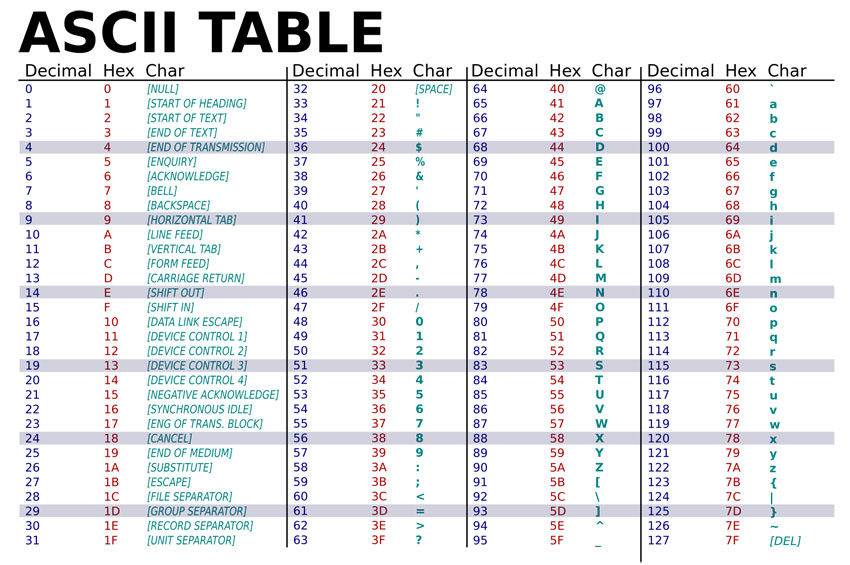

La stessa logica utilizzata per rappresentare i numeri può essere utilizzata per rappresentare un testo, servendosi di uno schema di codifica – un codice appunto – che traduca ogni lettera o variante in una notazione binaria, a cui si aggiungono punteggiatura e simboli speciali: un totale di circa 100 caratteri. In nostro aiuto vengono i cosiddetti set di caratteri, di cui i più conosciuti ed usati sono ASCII e Unicode.

Il loro funzionamento è simile: l’ASCI ad esempio, è stato inizialmente sviluppato per il telegrafo, e nella versione originaria usava 7 bit per rappresentare 128 caratteri diversi (2 alla settima potenza). I set di caratteri sviluppati successivamente hanno poi ampliato la disponibilità di bit fino a raggiungere gli attuali 32 bit, aumentando vertiginosamente la quantità di caratteri disponibili. Unicode, però, è attualmente lo standard del testo accettato a livello mondiale, permettendo di coprire la maggior parte delle lingue esistenti.