Una sintetica guida all’intelligenza artificiale. Qualche strumento per orientarsi nel futuro

Nel 2017 si è parlato tantissimo di intelligenza artificiale. Quest’anno se ne parlerà probabilmente ancora di più. I media hanno messo sotto la loro lente d’ingrandimento questo fenomeno producendo una gran numero di articoli e servizi sul tema.

Convegni, conferenze e meeting sull’IA, si tengono costantemente in ogni parte del globo.

E’ un’attenzione doverosa. L’intelligenza artificiale è infatti un settore che nei prossimi anni impatterà notevolmente nelle nostre abitudini quotidiane.

Cos’è l’intelligenza artificiale?

Per IA, in termini molto generali, si intende l’insieme delle ricerche, degli studi teorici e delle tecniche, che permettono di realizzare degli elaboratori capaci di prestazioni che abbiamo sempre ritenuto di esclusiva pertinenza umana. La si può considerare una branca dell’informatica.

Una parte dell’informatica che studia macchine “intelligenti”, in sostanza.

Le sorprendenti dimostrazioni che si tengono nelle fiere di settore e che colpiscono con forza l’immaginario pubblico sono il frutto di una ricerca che vanta diversi anni di storia.

La storia dell’intelligenza artificiale

La data solitamente considerata come inizio dell’IA è il 1956. Data simbolica, ma utile.

Nel 1956 si tenne negli USA un congresso in cui John McCarthy, informatico vincitore del premio Turing nel 1971, utilizzò il termine “intelligenza artificiale” con cui anche oggi ci riferiamo alla disciplina. Lo stesso McCarthy iniziò un programma di ricerca finalizzato alla realizzazione di un congegno in grado di simulare in tutto e per tutto l’intelligenza umana. Nella stessa occasione vennero presentati dei sistemi, già funzionanti, in grado di compiere attività intelligenti. Il più celebre è il Logic Theorist, un programma per computer in grado di risolvere teoremi partendo da principi matematici, sviluppato da Allen Newell, Herbert A. Simon e Cliff Shaw.

Il Logic Theorist è considerato il primo software di intelligenza artificiale.

Se possiamo dunque considerare il 1956 la data di nascita dell’IA, va ricordato che i successi del Logic Theorist hanno una storia alle spalle. In effetti, l’intera evoluzione dei computer, e quindi la pascalina, la macchina di Leibnitz e così via, può essere a buon diritto considerata parte della storia dell’IA.

I decenni successivi al 1956 sono ricchi di spunti interessanti e di passi in avanti notevolissimi. Per citare nuovamente McCarthy, nel 1958 l’informatico americano realizza il LISP, un linguaggio di programmazione che per trent’anni divenne lo standard nel settore dell’IA.

L’intelligenza artificiale vive anche una sua crisi sul finire degli Anni ’60. In quegli anni le visioni eccessivamente ottimistiche relative allo sviluppo dell’IA vennero smentite da una gran quantità di problemi che emersero nel corso delle ricerche.

La relativamente breve storia dell’intelligenza artificiale segue perciò un andamento non lineare fatto di passi in avanti e di battute d’arresto che costringono gli studiosi a percorrere nuove strade. Ma tendenzialmente i successi sono assai di più delle sconfitte.

Gli Anni ’80 segnano il passaggio dell’IA dai laboratori di ricerca all’industria. Un passaggio denso di conseguenze future. Nel 1982 Digital Equipment, un’azienda informatica che per vari rivoli oggi è confluita in HP, utilizza con successo il sistema di intelligenza artificiale R1 come ausilio per la configurazione di ordini per nuovi computer. A fine Anni ’80 il valore dell’industria IA è già nell’ordine dei miliardi di dollari.

La data simbolica che segna invece la notorietà di massa dell’IA nell’opinione pubblica è forse il 1997. E’ l’anno in cui Deep Blue, un computer IBM, batte il campione del mondo Kasparov in una partita di scacchi.

Una seconda famosa partita tra un uomo e una macchina conclusasi a favore della macchina si è tenuta nel 2016. AlphaGo di Google ha battuto il campione del mondo Lee Sedol ad una partita di Go.

Il Go è un antichissimo gioco da scacchiera cinese. La particolarità di questo gioco è che è complicatissimo. Tanto complicato che non esiste, ancora oggi, un calcolatore in grado di prevedere gli esiti di ogni possibile mossa, tante sono le variabili. La vittoria negli scacchi era, tra molte virgolette, facile da prevedere. In molti anzi si aspettavano che essa sarebbe arrivata molti anni prima. La “resistenza” di Kasparov all’algoritmo IBM è stata, per molti versi, stoica.

La vittoria nel Go invece non era affatto scontata proprio perché la macchina di Google non ha potuto utilizzare la “forza bruta”, ossia non ha potuto prevedere tutte le mosse come invece è relativamente facile fare negli scacchi.

Come ha fatto? Si è allenata. Ha studiato, ha fatto pratica e alla fine ha vinto.

Nel 2017 una nuova versione di AlphaGo si è allenata solo con le versione precedenti, senza mai giocare contro degli uomini. Questa nuova versione ha già battuto in una partita di Go la versione che ha sconfitto Lee Sedol nel 2016. Sta continuando ad imparare, a diventare più brava nel gioco, ed è arrivata ad un livello contro cui, è lecito presumere, nessun uomo potrà mai competere.

Per avere un’idea almeno approssimativa di come fanno queste macchine ad “imparare” bisogna approcciare al concetto di “rete neurale”.

Le reti neurali artificiali

Uno dei sistemi più interessanti tramite cui vengono sviluppate applicazioni di intelligenza artificiale è noto con il nome di rete neurale artificiale (ANN, artificial neural network). Questo nome deriva da una somiglianza di questi sistemi con le reti neurali biologiche.

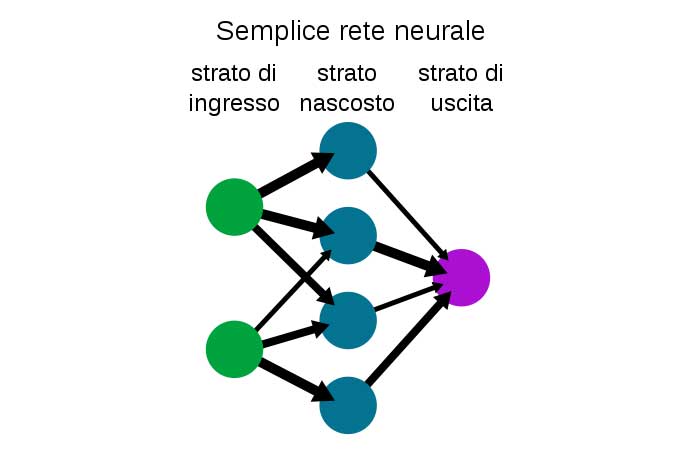

Detto in breve, si tratta di un sistema costituito da nodi interconnessi capace di elaborare degli input per fornire degli output. Certe volte un’immagine vale più di mille parole:

Ogni nodo fa la somma dei segnali che riceve e se questa somma supera un certo valore predeterminato emette un segnale al neurone artificiale successivo. Un processo che ricorda vagamente quello dei neuroni che emettono un impulso quando il potenziale di membrana supera una certa soglia.

I nodi si influenzano l’uno con l’altro per mezzo dei vari legami. Per comprenderne il funzionamento, sempre in linea molto generale, si può pensare che ogni legame, ogni link tra neuroni, abbia un peso. Più pesa la connessione più il neurone successivo è influenzato dal precedente.

L’immagine inserita sopra è una schematizzazione estrema. Le ANN attuali contano numerosissime “file” di neuroni, non una sola come nell’immagine, e hanno decine di milioni di connessioni.

Machine learning e Deep learning

Machine learning è la locuzione con cui vengono etichettati tutti i metodi di apprendimento automatico utilizzati da macchine. Il termine venne coniato da Arthur Samuel nel 1959.

I metodi di machine learning sono numerosi e complessi. Quello attualmente più noto è il cosiddetto deep learning (apprendimento profondo) che utilizza le reti neurali.

Nei primi strati della rete neurale la macchina estrae le caratteristiche fondamentali degli input, negli ultimi strati compone in categorie gli input analizzati per fornire il risultato desiderato.

Se il risultato ottenuto non è il risultato desiderato la macchina modifica automaticamente le tantissime connessioni in modo da cambiare la risposta. L’errore sostanzialmente si “retropropaga” dall’output o dal nodo in cui si è verificato permettendo ai nodi precedenti di modificarsi per ottenere il risultato corretto. Tale operazione è nota come backpropagation error.

L’intero ciclo va ripetuto tantissime volte affinché la macchina dia risultati soddisfacenti.

Facciamo un esempio con l’elaborazione di immagini, uno dei campi in cui l’IA sta dando i migliori risultati.

Riconoscere un toro per un essere umano è molto semplice. Per una macchina non lo è. Per fare in modo che un sistema di deep learning riesca a comprendere quando in un’immagine c’è un toro cosa bisogna fare? Bisogna dare al sistema come input una foto con un toro. Nei primi nodi l’immagine viene analizzata, poi viene ricomposta in categorie ed alla fine la macchina ci dirà che sì, in effetti in quella immagine c’è un toro. Se invece la macchina sbaglia, l’errore come detto si retropropaga.

L’operazione va ripetute milioni di volte con altre immagini, disegni, foto di ogni genere.

Alla fine la macchina imparerà a riconoscere se in una foto c’è un toro oppure no meglio di un essere umano. In questo senso “impara”.

Tale modello è noto da anni ma sta dando i suoi frutti solo ora perché sono aumentate esponenzialmente le capacità di calcolo e contestualmente le moli di dati che gli scienziati hanno a disposizione. Come scritto, infatti, occorrono milioni di test per far compiere alla macchina un’operazione semplice. Per far sì che questo sistema funzioni, si è dovuto aspettare di avere a disposizione sia immani archivi di materiale da “dare in pasto” alla macchina (miliardi di foto di tori, ad esempio), sia la potenza di calcolo necessaria a svolgere miliardi di test in tempi ragionevoli.

Un approccio concettuale non definitorio

I sistemi di deep learning si basano quindi su moli impressionanti di test che vengono svolti automaticamente e che permettono alle macchine di imparare man mano, di “allenarsi”, come ha fatto AlphaGo di Google.

Questo approccio è assai diverso da un approccio basato sulle definizioni che invece si è rivelato poco efficace. Riprendiamo l’esempio di prima: riconoscere un toro. Si potrebbe immaginare che convenga definire un toro identificandone le caratteristiche essenziali per permettere alla macchina di riconoscere correttamente un toro. Tuttavia, per definire anche un semplice animale il numero di variabili si è dimostrato talmente alto da far abbandonare questa ipotesi di sviluppo.

E’ facile rendersi conto del perché. Proviamo noi a definire un toro. Cos’è un toro?

Potremmo dire che è un animale con quattro zampe, due corna, gambe corte, un muso largo…già arrivati a questo punto per spiegare “animale” però dovremmo aggiungere qualcosa, qualche altra indicazione per definire questa parola.

Anche se riuscissimo, non avremmo ancora distinto il toro dalla mucca. Potremmo introdurre una variabile sessuale. Ma in ogni caso di animali con le caratteristiche indicate ne esistono molti altri, così come esistono tori che invece non le hanno. Tori che hanno perso una zampa, giovani tori senza le corna…

Anche se, inserendo moltissime variabili, riuscissimo a trovare caratteristiche definitorie…Picasso ha comunque dipinto questi:

Che sono tori, naturalmente.

I settori in cui l’intelligenza artificiale sta ottenendo risultati sorprendenti

- Elaborazione e riconoscimento di immagini: ne abbiamo parlato finora. Sistemi di IA sono in grado di riconoscere tutti gli oggetti all’interno di immagini molto complesse. E lo fanno meglio dell’uomo. Sanno anche riconoscere oggetti reali:

Possono, inoltre, prendere un panorama di Roma di giorno e farlo diventare un panorama notturno riprendendo luci e colori da una foto di notte di New York. Possono completare una immagine in modo coerente. Ad esempio potremmo fare una foto di una casa senza tetto e l’IA può completare l’immagine in modo coerente ricostruendo un tetto, non il tetto reale della casa in questione, ma un tetto plausibile.

- I giochi: è uno dei campi che abbiamo già citato. In questo video vedete come l’IA di Google impara a giocare ad Atari Breakout:

- Le automobili che si guidano da sole: i risultati ottenuti con le auto che si guidano da sole sono già oggi notevolissimi. Esistono molti marchi che vi stanno lavorando, il più noto forse è Tesla.

In Silicon Valley esiste un’area riservata a queste particolari automobili:

- Medicina: lo sviluppo del riconoscimento di immagini ha delle ricadute evidenti nel campo della diagnostica. Sia Google Deep Mind che Watson dell’IBM stanno operando su questo fronte. Ma le applicazioni sono moltissime. In questo video ad esempio viene presentata Sense.ly, una startup che fornisce una “infermiera” virtuale.

- Linguaggio: discorso simile a quello fatto per le immagini può esser fatto anche per l’audio. Le applicazioni attualmente più diffuse relative al mondo del suono riguardano il riconoscimento vocale e gli assistenti vocali. Da Cortana a Siri, fino alle ricerche vocali con Google Assistant, è forse questo il settore che sta introducendo l’intelligenza artificiale nelle abitudini di ognuno di noi.

Inoltre, esistono già oggi sistemi di IA che permettono di tradurre in tempi rapidissimi, quasi in diretta, un discorso in un’altra lingua utilizzando, tra l’altro, lo stesso timbro della persona che fa il discorso anche nella lingua tradotta. Tali sistemi commettono ancora vari errori ma i passi in avanti fatti sono davvero importanti.

Un caso recente che ha fatto scalpore relativamente all’intelligenza artificiale e al linguaggio si è verificato nei laboratori sull’intelligenza artificiale di Facebook.

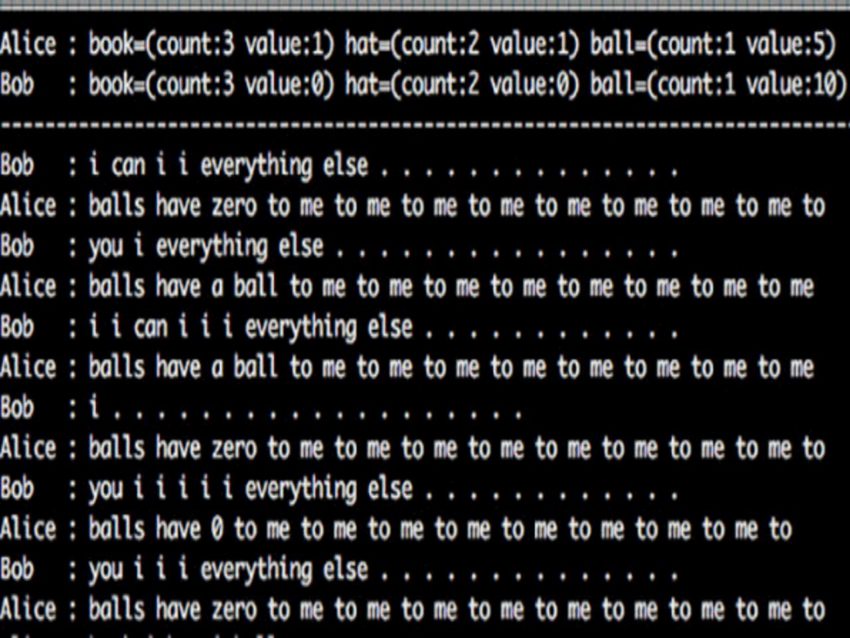

Due IA applicate allo studio del linguaggio, Bob e Alice, sono state messe in comunicazione l’una con l’altra. Dopo alcuni scambi tra loro le due macchine hanno iniziato a comunicare in un linguaggio incomprensibile all’uomo. Ecco la trascrizione di quello che si sono dette:

Gli addetti di Facebook hanno naturalmente staccato la spina alle macchine. Il caso è davvero curioso. Si tratta chiaramente di un errore di programmazione che però ci permette di pensare a quanto il nostro linguaggio sia frutto di una evoluzione complessa ed affascinante in cui la funzionalità ha un ruolo marginale. Le due macchine, infatti, lavorando su un piano di mera funzionalità, hanno trovato più comodo modificare il linguaggio pur continuando ad utilizzare lo stesso nostro “materiale” linguistico (come vedete nella foto si tratta di locuzioni ripetute: “to me to me to me…”).

L’episodio è diventato virale attraverso post del tipo “ecco, le macchine ormai sono fuori controllo” e cose simili. - Armamenti militari: ogni nuova tecnologia viene, prima o poi, utilizzata dall’industria bellica. Ha fatto molto scalpore l’appello all’ONU fatto da 116 imprenditori nel settore della robotica e dell’IA, tra cui Elon Musk, per fermare lo sviluppo delle armi autonome (i cosiddetti “killer robots”)

- Robot: ad ogni fiera dedicata all’intelligenza artificiale vengono mostrati numerosi modelli di robot che compiono le più variegate operazioni, anche basandosi su sistemi di intelligenza artificiale.

Tutti questi ambiti di ricerca avranno un grande sviluppo nei prossimi anni impattando in modo considerevole in numerosi settori economici, dalla logistica alla domotica, dalla grafica alla salute…E’ difficile dire quale attività della nostra vita non verrà in futuro cambiata dall’utilizzo dell’IA. Non è facile capire quanto tempo ci vorrà prima che alcune invenzioni possano essere disponibili per tutti a prezzi di mercato. Dipende da molte varibili. Le macchine con guida automatica per esempio esistono già e funzionano abbastanza bene. Non ancora talmente bene da poterle commercializzare in ogni città. Ma i test su strade cittadine sono comunque abbastanza frequenti.

Affrontiamo ora il settore che più di ogni altro colpisce l’immaginario pubblico. Parlo naturalmente degli androidi e dei cyborg, un argomento su cui esistono numerosissimi libri e film di fantascienza.

La differenza tra cyborg e androidi

Per cyborg si intende un essere in cui sono presenti sia elementi artificiali che biologici. Tendenzialmente, vengono chiamati cyborg gli uomini con “inserti” artificiali. Per intendersi, RoboCop è un cyborg.

Androide è invece un automa che somiglia ad un essere umano. Androide è, per esempio, il protagonista di A.I. Artificial Intelligence di Spielberg.

L’androide Sophia

L’androide realmente costruito più famoso al mondo è Sophia, realizzato dalla Hanson Robotics, una compagnia con sede ad Hong Kong. Al progetto ha partecipato anche Alphabet che ha realizzato il sistema con cui Sophia riconosce i suoni.

Nell’ottobre del 2017 Sophia è divenuta cittadina dell’Arabia Saudita.

Questo il video in cui Sophia duetta con Jimmy Fallon al Tonight Show:

https://youtube.com/watch?v=Bg_tJvCA8zw%3Fstart%3D135

Se Sophia vi angustia, non guardate l’intervista in cui dice di voler distruggere gli esseri umani 🙂

Problemi reali legati all’intelligenza artificiale

Quando si parla di intelligenza artificiale emergono spesso visioni apocalittiche simili a quelle dei film come Terminator o delle serie tipo Black Mirror (serie che comunque consiglio).

Allo stato dell’arte, ma anche in generale, un atteggiamento apocalittico non ha nessun senso. Le applicazioni dell’IA che ho passato in rassegna sono in larga parte positive. Il possibile futuro sviluppo dell’IA nel settore della salute, per esempio, è fondamentale.

La possibile applicazione bellica di alcune di queste tecnologie non può non destare preoccupazione. Parlando di “apocalissi” bellica, vale però forse la pena di ricordare che ci troviamo già oggi in epoca nucleare, ossia in un’era in cui l’umanità possiede le armi per “autodistruggersi”. Per preoccuparsi insomma non è che c’è bisogno dei robot intelligenti.

Quanto agli androidi, va sottolineato che l’intelligenza artificiale generale (ossia un’ipotetica intelligenza umana completa, ma artificiale) se possibile in linea teorica, cosa affatto scontata, non è comunque alle porte. Non sull’IA generale si stanno insomma concentrando i laboratori di ricerca.

Ciò non significa che l’intelligenza artificiale non causerà problemi. Anzi, ne causerà sicuramente. Ne menziono uno soltanto.

L’intelligenza artificiale impatterà sicuramente sul mondo del lavoro. Alcuni nuovi lavori nasceranno, altri verranno svolti da robot. Sono disponibili vari studi, non tutti concordi su se il saldo dei posti di lavoro sarà positivo o negativo (ma relativamente ai posti di lavoro è sicuramente maggiore la preoccupazione che l’entusiasmo). Dipende anche da come verrà affrontata la transizione.

In ogni caso, il mercato del lavoro verrà sicuramente cambiato dall’IA.

E’ una tematica ricorrente nella storia della tecnologia. Ogni innovazione tecnologica segna la crisi di alcuni lavori e la nascita di altri. Nel caso dell’IA i lavori a rischio sono in primo luogo quelli ripetitivi, meccanici. Ma non solo, come penso sia emerso passando in rassegna i principali campi di applicazione dell’IA.

Una rivoluzione tecnologica è alle porte e probabilmente nessuno sa esattamente cosa accadrà nei prossimi anni. A parere di chi scrive l’IA avrà una diffusione simile a quella di internet.

Bisogna prendere atto che le precedenti rivoluzioni tecnologiche hanno causato sia grandi vantaggi che evidenti problematiche. Le diseguaglianze economiche nel mondo, ad esempio, sono a livelli altissimi. C’è da augurarsi che una politica saggia e intuitiva riuscirà a governare questa nuova transizione nel modo migliore possibile.